- W poniedziałek Nvidia zaprezentowała H200, procesor graficzny zaprojektowany do trenowania i wdrażania typów modeli sztucznej inteligencji, które napędzają boom generatywnej sztucznej inteligencji.

- H200 zawiera 141 GB pamięci „HBM3” nowej generacji, która pomoże mu generować tekst, obrazy lub prognozy przy użyciu modeli AI.

- Zainteresowanie procesorami graficznymi Nvidii opartymi na sztucznej inteligencji zwiększyło dynamikę firmy, a sprzedaż w tym kwartale ma wzrosnąć o 170%.

Jensen Huang, prezes Nvidii, trzyma procesor Grace hopper używany w generatywnej sztucznej inteligencji podczas głównej prezentacji Supermicro podczas targów Computex 2023.

Walid Barazek | Rakieta Lite | Obrazy Getty’ego

W poniedziałek Nvidia zaprezentowała H200, procesor graficzny zaprojektowany do trenowania i wdrażania typów modeli sztucznej inteligencji, które napędzają boom generatywnej sztucznej inteligencji.

Nowy procesor graficzny jest ulepszeniem H100, chipa, którego OpenAI użył do szkolenia swojego najbardziej zaawansowanego modelu wielkojęzykowego, GPT-4. Duże firmy, start-upy i agencje rządowe konkurują o ograniczoną podaż chipów.

Raymond James szacuje, że chipy H100 kosztują od 25 000 do 40 000 dolarów, a do wspólnej pracy nad stworzeniem największych modeli w procesie zwanym „szkoleniem” potrzebne są tysiące z nich.

Ekscytacja wokół procesorów graficznych Nvidii wyposażonych w sztuczną inteligencję spowodowała gwałtowny wzrost cen akcji firmy, które w 2023 r. wzrosną o ponad 230%. Nvidia spodziewa się przychodów w trzecim kwartale finansowym na poziomie około 16 miliardów dolarów, co oznacza wzrost o 170% w porównaniu z rokiem ubiegłym.

Głównym ulepszeniem H200 jest to, że zawiera 141 GB pamięci „HBM3” nowej generacji, która pomoże chipowi wykonywać „heurystyki” lub wykorzystywać duży model po przeszkoleniu go do generowania tekstu, obrazów lub przewidywań.

Nvidia twierdzi, że H200 będzie generować dane wyjściowe prawie dwukrotnie szybciej niż H100. Opiera się to na testach z Meta’s Llama 2 LLM.

H200, który ma zostać dostarczony w drugim kwartale 2024 roku, będzie konkurencją dla procesora graficznego AMD MI300X. Układ AMD, podobnie jak H200, ma dodatkową pamięć w porównaniu do swoich poprzedników, co pomaga dużym modelom zmieścić się na sprzęcie w celu uruchamiania wnioskowań.

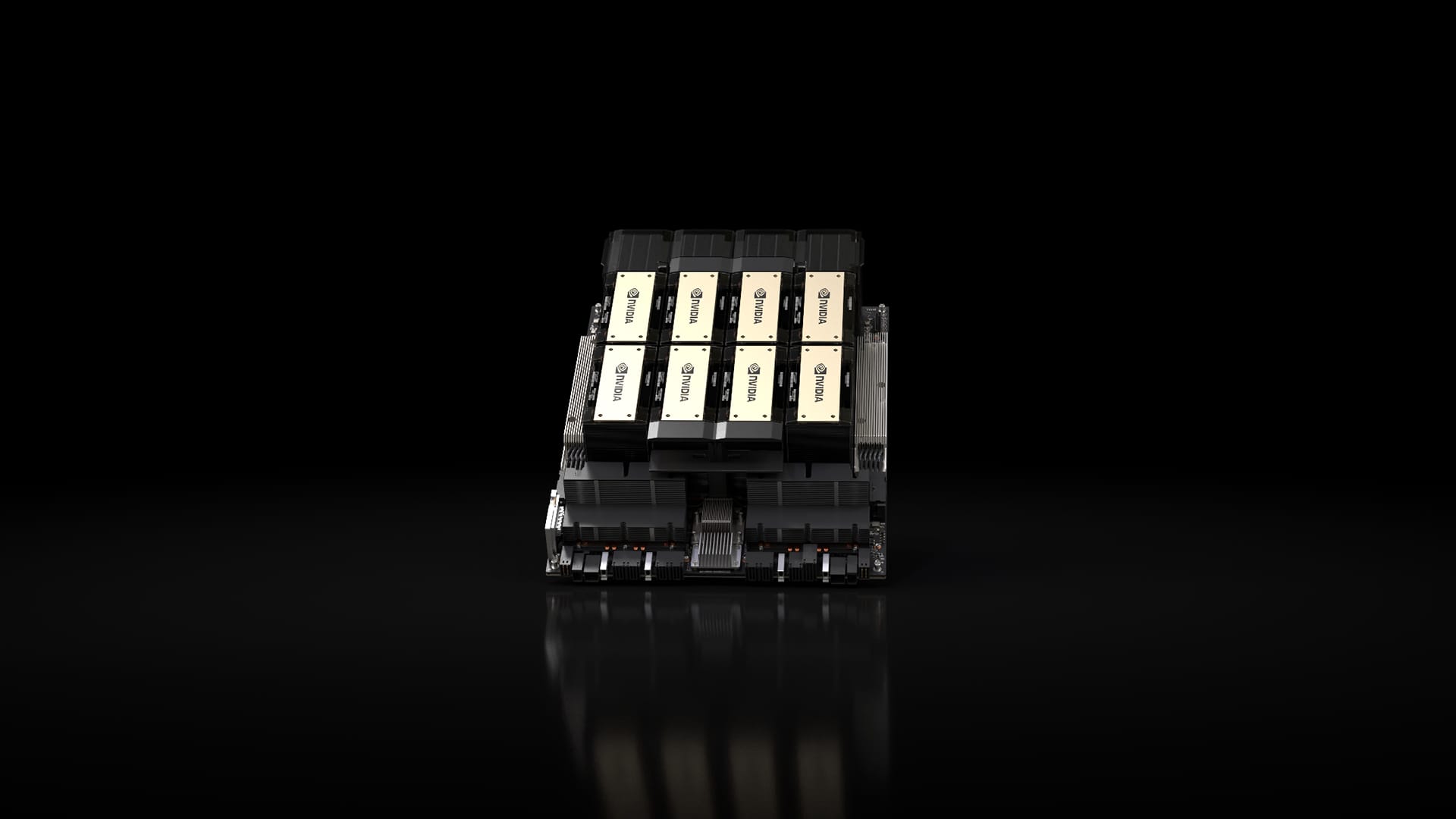

Chipset Nvidia H200 w systemie Nvidia HGX z ośmioma procesorami graficznymi.

Nvidia

Nvidia stwierdziła, że H200 będzie kompatybilny z H100, co oznacza, że firmy zajmujące się sztuczną inteligencją już szkolące się na poprzednim modelu nie będą musiały zmieniać swoich systemów serwerowych ani oprogramowania, aby korzystać z nowej wersji.

Nvidia twierdzi, że będzie dostępny w konfiguracjach serwerów z czterema lub ośmioma procesorami graficznymi na pełnych systemach HGX firmy, a także w chipie o nazwie GH200, który łączy procesor graficzny H200 z procesorem opartym na architekturze ARM.

H200 może jednak nie utrzymać długo korony najszybszego chipa Nvidia AI.

Chociaż firmy takie jak Nvidia oferują wiele różnych konfiguracji swoich chipów, nowe półprzewodniki często robią duży krok naprzód mniej więcej co dwa lata, kiedy producenci przechodzą na inną architekturę, która zapewnia bardziej znaczący wzrost wydajności niż dodanie pamięci lub inne mniejsze ulepszenia. H100 i H200 oparte są na architekturze Hopper firmy Nvidia.

W październiku Nvidia poinformowała inwestorów, że ze względu na duży popyt na procesory graficzne przejdzie z dwuletniego cyklu architektonicznego na roczny cykl wydawniczy. Firma oferowała Sugeruje slajd Ogłosi i wypuści chip B100 oparty na nadchodzącej architekturze Blackwell w 2024 roku.

On ogląda: Mocno wierzymy w trend sztucznej inteligencji, który nabierze tempa w przyszłym roku

Nie przegap tych historii z CNBC PRO:

„Odkrywca. Nieprzepraszający przedsiębiorca. Fanatyk alkoholu. Certyfikowany pisarz. Wannabe tv ewangelista. Fanatyk Twittera. Student. Badacz sieci. Miłośnik podróży.”