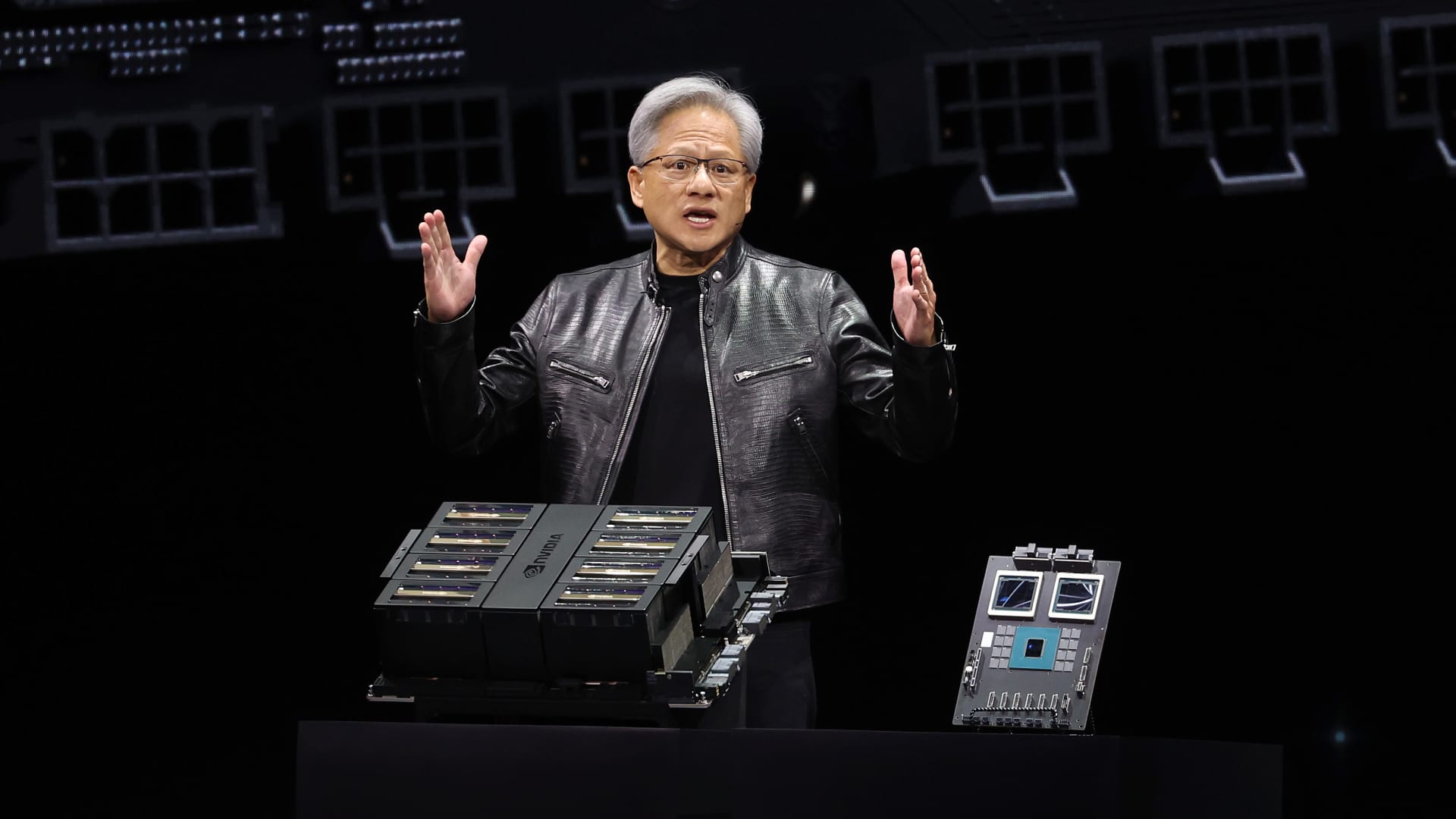

Dyrektor generalny Nvidii, Jensen Huang, wygłasza przemówienie programowe podczas konferencji Nvidia GTC AI w SAP Center 18 marca 2024 r. w San Jose w Kalifornii.

Justin Sullivan | Obrazy Getty’ego

Nvidia W poniedziałek ogłosiła nową generację chipów i oprogramowania AI do zasilania modeli AI. Oświadczenie ogłoszone podczas konferencji programistów Nvidia w San Jose wynika z chęci umocnienia przez producenta chipów pozycji głównego dostawcy dla firm zajmujących się sztuczną inteligencją.

Cena akcji Nvidii wzrosła pięciokrotnie, a całkowita sprzedaż wzrosła ponad trzykrotnie, odkąd ChatGPT OpenAI wywołał boom na sztuczną inteligencję pod koniec 2022 roku. Najnowocześniejsze procesory graficzne Nvidii dla serwerów są niezbędne do szkolenia i wdrażania dużych modeli sztucznej inteligencji. Firmy takie jak Microsoftu I martwy Na zakup chipsów wydano miliardy dolarów.

Nowa generacja procesorów graficznych wykorzystujących sztuczną inteligencję nosi nazwę Blackwell. Pierwszy chip Blackwell nosi nazwę GB200 i zostanie dostarczony jeszcze w tym roku. Nvidia kusi swoich klientów mocniejszymi chipami, aby pobudzić nowe zamówienia. Na przykład firmy i twórcy oprogramowania wciąż starają się uzyskać chipy „Hopper” H100 i podobne chipy obecnej generacji.

„Hopper jest świetny, ale potrzebujemy większych procesorów graficznych” – powiedział dyrektor generalny Nvidii Jensen Huang w poniedziałek na konferencji programistów firmy w Kalifornii.

Akcje Nvidii spadły o ponad 1% w przedłużonych poniedziałkowych notowaniach.

Firma wprowadziła także program generujący przychody o nazwie NIM, który ułatwi wdrażanie sztucznej inteligencji, dając klientom kolejny powód do dalszego korzystania z chipów Nvidia w obliczu rosnącej konkurencji.

Dyrektorzy Nvidii twierdzą, że firma przestała być najemnym dostawcą chipów, a bardziej dostawcą platform, takich jak Microsoft czy Apple, na których inne firmy mogą tworzyć oprogramowanie.

„Blackwell to nie chip, to nazwa platformy” – powiedział Huang.

„Produktem dostępnym na rynku był procesor graficzny, a oprogramowanie miało pomóc ludziom w korzystaniu z procesora graficznego na różne sposoby” – powiedział w wywiadzie wiceprezes Fundacji Nvidia Manuvir Das. „Oczywiście nadal to robimy. Ale tak naprawdę zmieniło się to, że mamy teraz firmę zajmującą się oprogramowaniem biznesowym”.

Das powiedział, że nowe oprogramowanie Nvidii ułatwi uruchamianie oprogramowania na dowolnym procesorze graficznym Nvidii, nawet starszym, który może lepiej nadawać się do wdrożenia, ale nie do budowania sztucznej inteligencji.

„Jeśli jesteś programistą i masz ciekawy model, który chcesz, aby ludzie zaadoptowali, jeśli umieścisz go w NIM, upewnimy się, że będzie można go odtwarzać na wszystkich naszych procesorach graficznych, dzięki czemu możesz dotrzeć do wielu osób” Das powiedział.

Poznaj Blackwella, następcę Hoppera

Nvidia GB200 Grace Blackwell Superchip z dwoma procesorami graficznymi B200 i jednym procesorem opartym na ARM.

Co kilka lat Nvidia aktualizuje swoją architekturę GPU, odblokowując ogromny skok wydajności. Wiele modeli sztucznej inteligencji wydanych w ciągu ostatniego roku zostało przeszkolonych w oparciu o architekturę Hopper firmy, z której korzystają chipy takie jak H100, która zostanie ogłoszona w 2022 roku.

Nvidia twierdzi, że procesory oparte na Blackwell, takie jak GB200, oferują firmom zajmującym się sztuczną inteligencją ogromny wzrost wydajności, wynoszący 20 petaflopów w porównaniu z 4 petaflopami w przypadku H100. Nvidia twierdzi, że dodatkowa moc obliczeniowa umożliwi firmom zajmującym się sztuczną inteligencją trenowanie większych, bardziej złożonych modeli.

Chip zawiera to, co Nvidia nazywa „silnikiem transformatorowym zaprojektowanym specjalnie do zasilania sztucznej inteligencji opartej na transformatorach, jednej z podstawowych technologii leżących u podstaw ChatGPT”.

Procesor graficzny Blackwell jest duży i łączy dwie oddzielnie wyprodukowane matryce w jeden chip wyprodukowany przez TSMC. Będzie również dostępny jako kompletny serwer o nazwie GB200 NVLink 2, zawierający 72 procesory graficzne Blackwell i inne części Nvidii przeznaczone do trenowania modeli AI.

Dyrektor generalny Nvidii, Jensen Huang, porównuje rozmiar nowego chipa „Blackwell” z obecnym chipem „Hopper” H100 podczas konferencji programistów firmy w San Jose w Kalifornii.

Nvidia

Amazonka, Google, MicrosoftuI Inspiracja Będziesz sprzedawać dostęp za GB200 poprzez usługi w chmurze. GB200 łączy w sobie dwa procesory graficzne B200 Blackwell z jednym procesorem Grace opartym na architekturze ARM. Nvidia powiedziała, że Amazon Web Services zbuduje farmę serwerów zawierającą 20 000 chipów GB200.

Nvidia twierdzi, że system może wdrożyć model zawierający 27 bilionów parametrów. To znacznie więcej niż nawet największe modele, takie jak GPT-4, który podobno zawiera 1,7 biliona parametrów. Wielu badaczy sztucznej inteligencji uważa, że większe modele zawierają więcej parametrów i danych Może odblokować nowe umiejętności.

Nvidia nie podała ceny nowego GB200 ani zastosowanych w nim układów. Według szacunków analityków, procesor H100 oparty na technologii Hopper firmy Nvidia kosztuje od 25 000 do 40 000 dolarów za chip, a kompletne systemy kosztują do 200 000 dolarów.

Nvidia będzie również sprzedawać procesory graficzne B200 jako część kompletnego systemu zajmującego całą szafę serwerową.

Heurystyka mikroserwisów Nvidii

Nvidia ogłosiła również, że dodaje nowy produkt o nazwie NIM, co oznacza Nvidia Inference Microservice, do swojej subskrypcji programu Nvidia Enterprise.

NIM ułatwia wykorzystanie starszych procesorów graficznych Nvidia do wnioskowania lub procesu uruchamiania programów AI i umożliwi firmom dalsze korzystanie z setek milionów procesorów graficznych Nvidia, które już posiadają. Wnioskowanie wymaga mniejszej mocy obliczeniowej niż wstępne szkolenie nowego modelu sztucznej inteligencji. NIM umożliwia firmom, które chcą uruchamiać własne modele sztucznej inteligencji, zamiast kupować dostęp do wyników sztucznej inteligencji w ramach usługi od firm takich jak OpenAI.

Strategia polega na tym, aby klienci kupujący serwery oparte na procesorach Nvidia subskrybowali usługę Nvidia Enterprise, której licencja kosztuje 4500 USD na procesor graficzny rocznie.

Nvidia będzie współpracować z firmami zajmującymi się sztuczną inteligencją, takimi jak Microsoft czy Hugging Face, aby mieć pewność, że jej modele AI są dostrojone do działania na wszystkich kompatybilnych chipach Nvidia. Następnie, korzystając z NIM, programiści mogą wydajnie uruchamiać model na własnych serwerach lub serwerach Nvidii opartych na chmurze, bez długiego procesu konfiguracji.

„W moim kodzie, w którym wywoływałem OpenAI, zamieniłbym jedną linię kodu, aby wskazywała NIM otrzymany od Nvidii” – powiedział Das.

Nvidia twierdzi, że oprogramowanie pomoże również AI działać na laptopach wyposażonych w procesor graficzny, a nie na serwerach w chmurze.

„Odkrywca. Nieprzepraszający przedsiębiorca. Fanatyk alkoholu. Certyfikowany pisarz. Wannabe tv ewangelista. Fanatyk Twittera. Student. Badacz sieci. Miłośnik podróży.”