O ile pierwsze układy bazują na nadchodzącym Intel Meteor Lake (14y Systemy Gen Core są nadal niedostępne przez co najmniej kilka miesięcy — a zatem daleko im do popisu na targach Computex — Intel już kładzie podwaliny pod wyczekiwaną premierę Meteor Lake. Na tegorocznym pokazie, który szybko staje się wydarzeniem skoncentrowanym na sztucznej inteligencji, Intel wykorzystuje Computex do nakreślenia swojej wizji wnioskowania AI po stronie klienta dla systemów następnej generacji. Obejmuje to kilka nowych ujawnień na temat sprzętu przetwarzającego sztuczną inteligencję, który znajdzie się w urządzeniach Intel Meteor Lake, a także tego, czego Intel oczekuje od systemów operacyjnych i twórców oprogramowania z nowymi możliwościami.

Naturalnie sztuczna inteligencja szybko stała się modnym słowem w branży technologicznej w ciągu ostatnich kilku miesięcy, zwłaszcza po publicznym wprowadzeniu ChatGPT i zwiększonym zainteresowaniu tym, co obecnie nazywa się „generatywną sztuczną inteligencją”. Tak więc, podobnie jak na wczesnych etapach wdrażania innych głównych nowych technologii komputerowych, zarówno dostawcy sprzętu, jak i oprogramowania wciąż są w trakcie określania, co można zrobić z tą nową technologią i jakie są najlepsze projekty sprzętu, aby ją napędzać. A za tym wszystkim… powiedzmy po prostu, że na firmy, które odniosą sukces w tym nowym wyścigu AI, czeka wiele potencjalnych dochodów.

Intel ze swojej strony nie jest obcy sprzętowi AI, choć z pewnością nie jest to obszar, który zwykle otrzymuje najwyższe rachunki w firmie znanej z procesorów i fabryk (w tej kolejności). Wśród spółek zależnych należących w całości do Intela w tym obszarze znajduje się Movidius, który produkuje jednostki przetwarzania obrazu o niskim poborze mocy (VPU) oraz Habana Labs, która jest odpowiedzialna za rodzinę najnowocześniejszych akceleratorów głębokiego uczenia Gaudiego. Ale nawet w ramach produktów klienckich Intela, firma Intel włączyła kilka rdzeni sprzętowych AI o bardzo niskim poborze mocy w postaci pakietu Gaussian & Neural Accelerator (DNA) do przetwarzania dźwięku, który jest w rodzinie Core od architektura Jeziora Lodowego.

Jednak w 2023 roku wiatr wyraźnie wieje w kierunku dodawania kolejnych maszyn AI na każdym poziomie, od klienta do serwera. Tak więc w przypadku Computex Intel ujawnia nieco więcej na temat swoich wysiłków w zakresie sztucznej inteligencji w Meteor Lake.

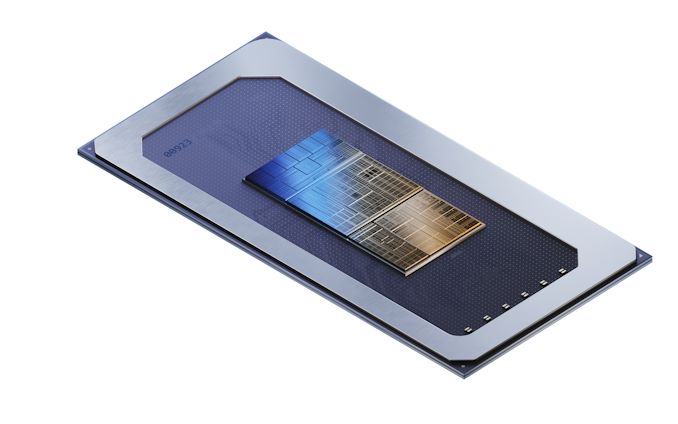

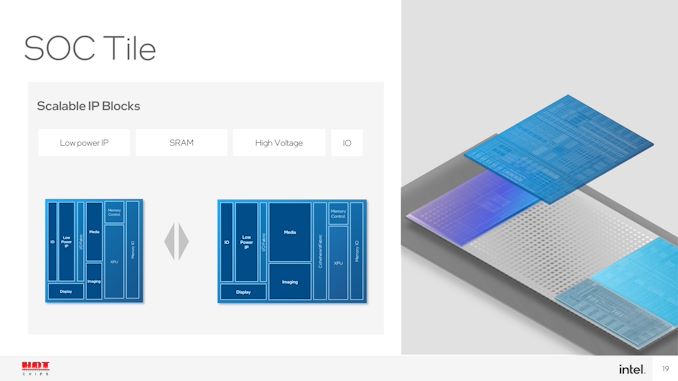

Meteor Lake: Płytka SoC zawiera VPU wywodzący się z Movidiusa do wnioskowania AI o niskim poborze mocy

Jeśli chodzi o sprzęt, wielkim odkryciem Intela jest to, że, jak od dawna podejrzewaliśmy, Intel przechowuje część swojego najpotężniejszego sprzętu AI w ocenianym SoC. Wcześniej dokumentowany w niektórych ofertach Intela jako blok „XPU” w kafelku Meteor Lake SoC (środkowy kwadrat), Intel potwierdza teraz, że ten XPU jest pełnoprawnym blokiem akceleracji AI.

W szczególności blok wywodzi się z projektu trzeciej generacji Vision Processing Unit (VPU) firmy Movidius, a w przyszłości jest odpowiednio identyfikowany przez firmę Intel jako VPU.

Ilość szczegółów technicznych dostarczanych przez Intela na temat bloku VPU dla Computex jest ograniczona — nie mamy żadnych danych dotyczących wydajności ani pojęcia, ile miejsca zajmuje układ SoC. Ale najnowszy VPU Movidiusa, Myriad X, zawierał dość elastyczny neuronowy silnik obliczeniowy, który był odpowiedzialny za zapewnienie VPU możliwości sieci neuronowej. Silnik w Myriad X jest oceniany na 1 TOPS przepustowości, chociaż prawie 6 lat i kilka praktycznych dekad później Intel prawie na pewno celuje w Meteor Lake znacznie wyżej.

Ponieważ jest częścią kafelka Meteor Lake SoC, VPU będzie obecne we wszystkich jednostkach SKU Meteor Lake. Intel nie użyłby go jako selektora funkcji, w ECC, a nawet w zintegrowanej grafice; Będzie to więc niezbędna funkcja dostępna dla wszystkich części opartych na Lake Meteor.

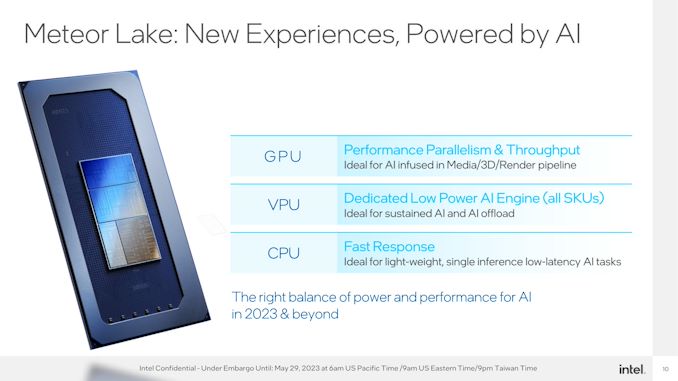

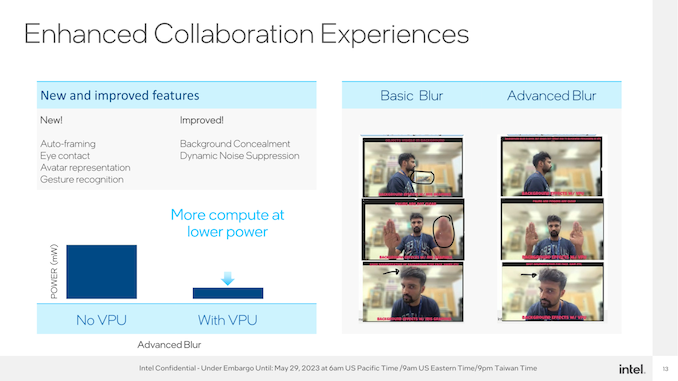

Z kolei celem VPU jest zapewnienie opcji trzeciej szyny do przetwarzania AI. W przypadku potrzeb o wysokiej wydajności istnieje zintegrowany procesor graficzny, którego duża liczba jednostek ALU może zapewnić stosunkowo duże ilości przetwarzania matematyki macierzowej stojącej za sieciami neuronowymi. Tymczasem CPU nadal będzie preferowanym procesorem dla prostych obciążeń roboczych o małych opóźnieniach, które nie mogą czekać na inicjalizację VPU lub gdy rozmiar obciążenia po prostu nie uzasadnia wysiłku. To pozostawia VPU na środku, jako dedykowany, ale energooszczędny akcelerator AI do ciągłego obciążenia AI, który nie potrzebuje wydajności (i mocy) GPU.

Warto również zauważyć, że chociaż nie jest to wyraźnie widoczne na schematach Intela, blok GNA będzie nadal obecny w Meteor Lake. Jego specjalnością jest działanie przy bardzo niskim poborze mocy, więc nadal jest wymagane do takich rzeczy, jak brzęczenie dźwięku i kompatybilność z istniejącym oprogramowaniem obsługującym GNA.

Potem pozostaje wiele rzeczy, których nie wiemy o VPU Meteor Lake. Fakt, że nazywa się to nawet VPU i zawiera technologię Movidius, oznacza, że jest to projekt skoncentrowany na wizji komputerowej, podobny do oddzielnych VPU Movidiusa. Jeśli tak, Meteor Lake VPU może przodować w obsłudze obciążeń wizualnych, ale brakuje mu wydajności i elastyczności w innych obszarach. I chociaż dzisiejsze ujawnienie ujawnienia Intela szybko przywodzi na myśl pytania o to, jak ten blok wypada w porównaniu pod względem wydajności i funkcjonalności z pakietem opartym na sztucznej inteligencji AMD Ryzen, są to pytania, które będą musiały poczekać na kolejny dzień.

Przynajmniej na razie Intel czuje się dobrze przygotowany do kierowania transformacją AI w przestrzeni klienckiej. I chcą, aby świat o tym wiedział — zarówno programiści, jak i użytkownicy.

Strona oprogramowania: co robisz z AI?

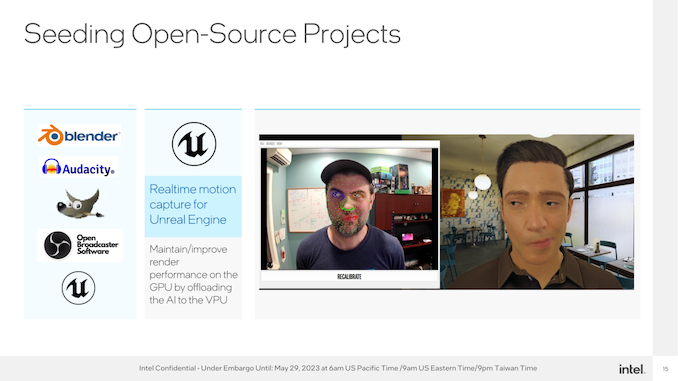

Jak wspomniano we wstępie, sprzęt to tylko połowa równania, jeśli chodzi o oprogramowanie do akceleracji AI. Ważniejsze od tego, co na nim uruchomić, jest to, co z nim zrobić, i nad tym Intel i jego partnerzy w zakresie oprogramowania wciąż pracują.

Najprościej rzecz ujmując, włączenie VPU zapewnia dodatkową wydajność oszczędzania energii podczas wykonywania zadań, które na niektórych platformach już dziś opierają się na sztucznej inteligencji w takiej czy innej formie, takich jak dynamiczne tłumienie szumów i segmentacja tła. Pod tym względem włączenie VPU dogania SoC klasy smartfonów, gdzie takie rzeczy jak Neural Engine firmy Apple i Hexagon NPU firmy Qualcomm zapewniają dziś podobne przyspieszenie.

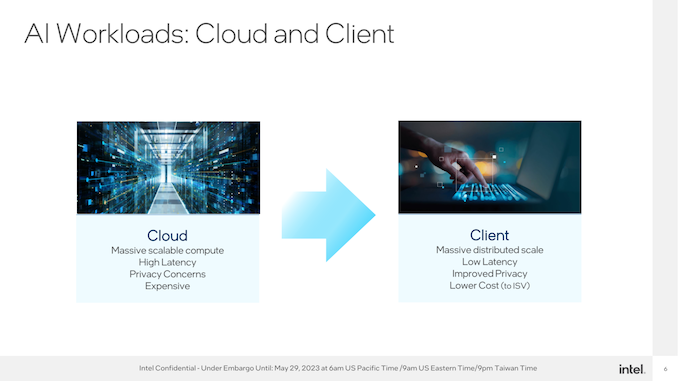

Ale Intel ma na celu znacznie większą nagrodę. Obaj chcą promować przenoszenie istniejących obciążeń serwerów AI na brzeg — innymi słowy, przeniesienie przetwarzania AI na klienta — a także promowanie zupełnie nowych obciążeń AI.

Jakie są w tym momencie, dopiero się okaże. Microsoft wyrzucił kilka własnych pomysłów w zeszłym tygodniu na dorocznej konferencji Build, w tym ogłoszenie Funkcja drugiego pilota dla systemu Windows 11. Dostawca systemu operacyjnego kładzie również pewne podstawy dla programistów za pomocą środowiska uruchomieniowego Open Neural Network Exchange (ONNX).

Do pewnego stopnia cały świat technologii znajduje się w punkcie, w którym ma nowy młotek, a teraz wszystko zaczyna wyglądać jak gwóźdź. Intel ze swojej strony z pewnością nie został w tym pominięty, ponieważ dzisiejsze ujawnienie jest bardziej ambitne niż konkretne korzyści po stronie oprogramowania. Ale to naprawdę są początki sztucznej inteligencji i nikt nie ma dobrego wyczucia, co może, a czego nie może zrobić. Jasne, jest kilka gwoździ do wbicia.

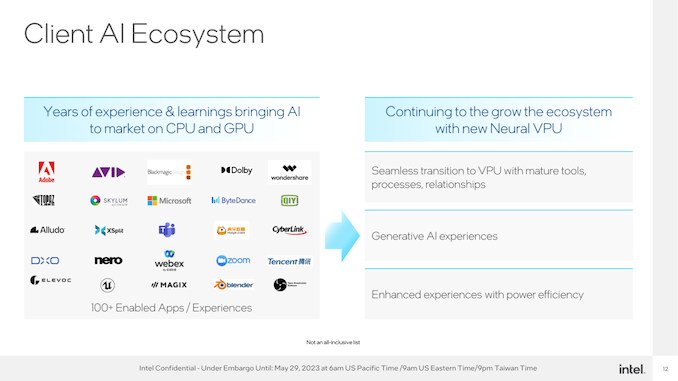

W tym celu Intel stara się wspierać ekosystem sztucznej inteligencji typu „wbuduj i przyjdź” w przestrzeni PC. Zapewnij cały sprzęt, współpracuj z firmą Microsoft, aby zapewnić narzędzia programowe i interfejsy API potrzebne do korzystania ze sprzętu, i zobacz, jakie nowe doświadczenia mogą wymyślić programiści — lub ewentualnie, jakie obciążenia mogą przenieść na VPU, aby zmniejszyć zużycie energii.

Intel przewiduje, że ostatecznie obciążenia oparte na sztucznej inteligencji zmienią wrażenia użytkownika komputera. To, czy tak się stanie, czy nie, wystarczy, aby zapewnić, że sprzęt wykona zadanie w następnej generacji procesorów.

„Specjalista sieciowy. Odwieczny maniak zombie. Kawowy ninja. Przyjazny dla hipsterów analityk.”

More Stories

Rabbit's R1 to mały gadżet napędzany sztuczną inteligencją, który rośnie w Tobie

Apple udostępnia modele AI typu open source działające na urządzeniu

Aktualizacje łatek Eiyuden Chronicle: Hundred Heroes są już dostępne